AI의 발전은 세 차례에 걸쳐 크게 변화해왔습니다.

1차 AI 붐에서는 규칙 기반 시스템이 주목받으며 AI의 기초가 다져졌습니다.

이후 2차 AI 붐에서는 머신러닝의 등장과 역전파 알고리즘 덕분에 신경망 학습이 가능해지면서 AI 연구가 다시 활기를 띠었습니다.

3차 AI 붐에 이르러서는 딥러닝과 생성형 AI가 발전하여 다양한 산업에서 혁신적인 성과를 내고 있습니다.

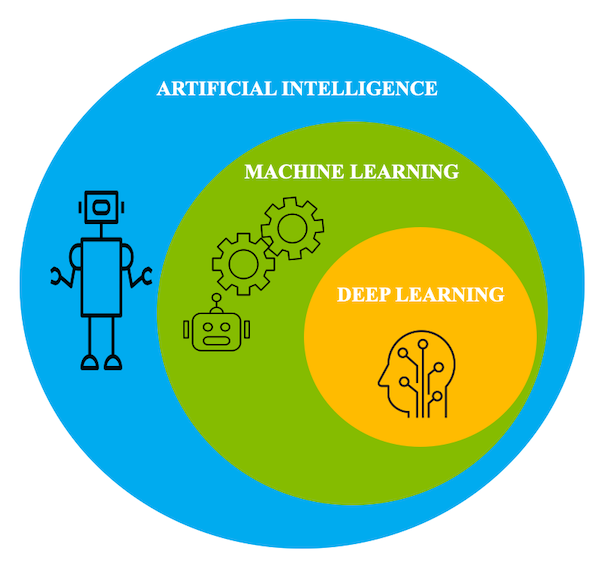

위의 사진을 보면, 머신러닝이 등장하고나서 순차적으로 딥러닝이 등장할 것 같다고 생각할 수 있지만, 실제로는 동시에 발전해왔습니다.

머신러닝과 딥러닝의 상호발전과 계층구조

예를들어,1980년대 역전파 알고리즘의 도입은 머신러닝의 중요한 발전이었습니다.이를 통해 비선형 문제를 해결할 수 있게 되었고, 딥러닝은 더 깊은 신경망으로 복잡한 패턴을 인식할 수 있었습니다.

머신러닝의 발전이 딥러닝의 기반을 마련했고, 딥러닝은 다시 머신러닝의 적용 범위를 넓혔습니다.

이 맥락에서 용어를 정리해보면, AI는 가장 넓은 개념으로, 인간의 지능을 모방해 문제를 해결하는 기술입니다.

머신러닝은 AI의 한 분야로, 데이터를 기반으로 스스로 학습하는 알고리즘입니다.

딥러닝은 머신러닝의 하위 개념으로, 신경망의 다층 구조를 이용해 복잡한 패턴을 학습하는 기술입니다.

따라서 AI는 머신러닝을 포함하고, 머신러닝은 딥러닝을 포함하는 계층 구조로 볼 수 있습니다.

AI의 태동

- 1950년

영국의 수학자 앨런 튜링(Alan Turing)은 기계가 생각할 수 있다고 주장하며, 이를 테스트하기 위한 방법으로 ‘튜링테스트

(The Turing Test)’를 고안함

=> AI 개념을 최초로 제시 - 1956년

AI개념을 세상에 알린 다트머스 회의(Dartmouth Conference)가 열림

여기서 기계가 인간처럼 학습하고 발전할 수 있는지 토론이 이루어짐

=> 용어 ‘AI’ 최초로 사용 - 1957년

프랑크 로젠블랏(Frank Rosenblatt)은 ‘단층 퍼셉트론(Perceptron)’ 모델 제시

컴퓨터가 패턴을 인식하고 학습할 수 있다는 개념을 실증적으로 보여줌

=> ‘신경망’ 이론을 테스트에 활용

- 1959년

아서 새뮤얼(Arthur Samuel)이 체커(체스와 유사한 게임) 프로그램을 개발하면서

용어 ‘머신러닝(Machine Learning)’ 사용

=> 머신러닝 : 컴퓨터가 명시적인 프로그래밍 없이 학습할 수 있는 능력

1차 침체기

- 환경적 이유

1. 과도한 기대와 현실의 차이

빠른 속도로 기계가 지능을 가지거나 인간처럼 사고하는 시스템이 등장하지 않았기 때문에, 대중과 정부의 실망이 커졌음

2. 연구 자금 감소

AI가 기대했던 결과를 내지 못하자 정부와 민간 연구소는 AI 연구에 대한 자금 지원을 축소 - 기술적 이유

1. 퍼셉트론의 한계

당시의 퍼셉트론은 선형 문제만 해결할 수 있었고, 비선형 문제(예: XOR 문제) 같은 복잡한 문제는 해결하지 못했음

2. 컴퓨팅 자원과 데이터의 부족

- 1950~1960년대의 컴퓨터는 매우 느렸고, 저장 용량도 한정적

- AI가 학습할 수 있는 데이터의 양이 부족

다층 퍼셉트론 이론 발표

- 1986년

힌튼은 인공신경망을 여러 겹 쌓은 다층 퍼셉트론(Multi-Layer Perceptrons) 이론에 ‘역전파 알고리즘’을 적용하여

기존 퍼센트론의 문제를 해결할 수 있음을 증명했다.

*역전파(Backpropagation) 알고리즘

인공신경망에서 출력과 실제 값 사이의 차이를 계산한 후, 이 오차를 최소화하기 위해 가중치를 조절하는 과정을 거꾸로 수행하는 알고리즘

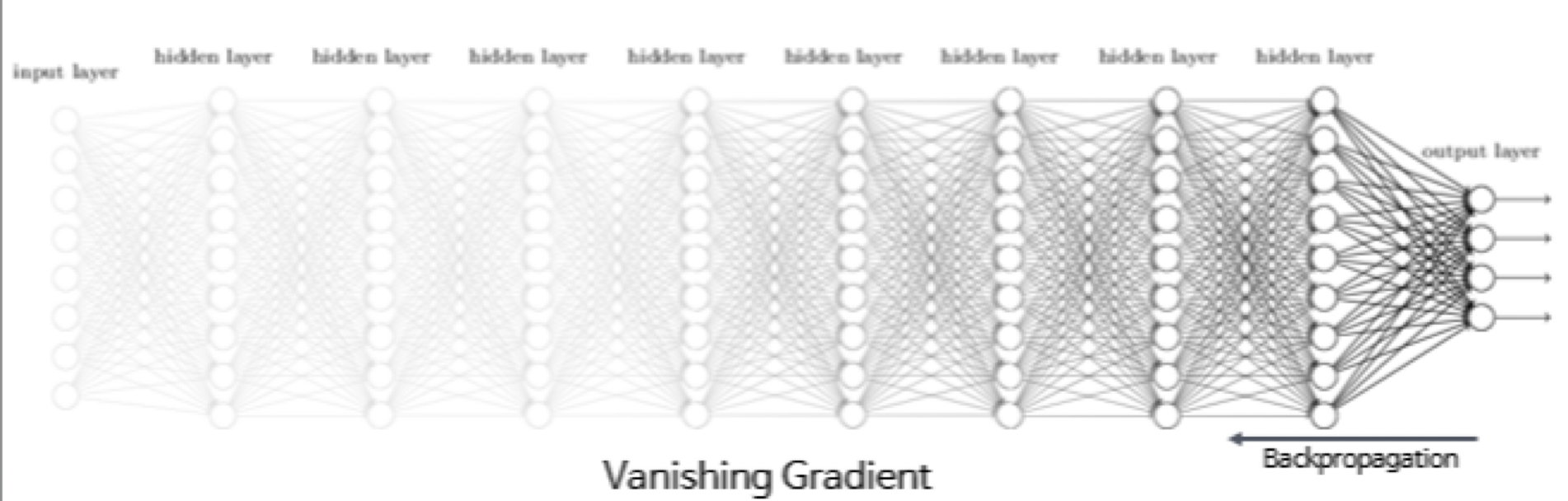

하지만, 이 알고리즘으로는 신경망의 깊이가 깊어질수록 학습과정과 결과에 이상이 나타남

=> 기울기 소실(Gradient Vanishing) 문제

기울기 소실이 일어나는 예시

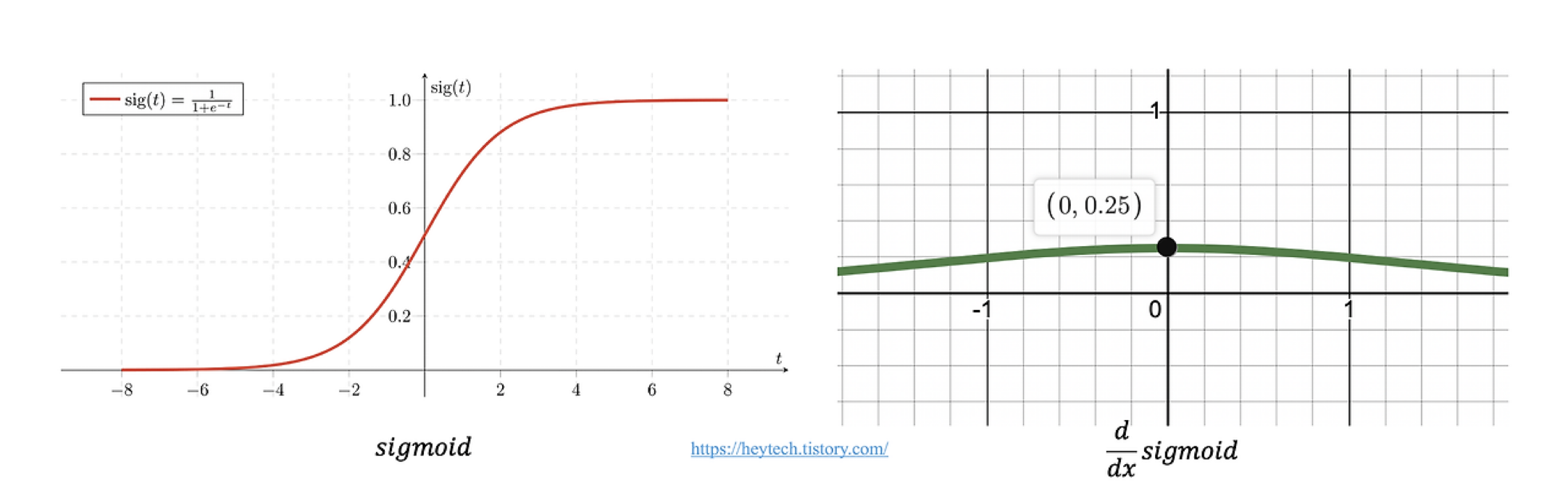

시그모이드 함수

1. 시그모이드 함수의 기울기 값

항상 0과 0.25 사이에 있음

2. 역전파 과정에서의 오차

오차 = 실제값 - 출력값

Step 1.출력층에서 오차와 기울기 계산

출력값 = 0.8 실제 값 =1 오차 = 0.2

기울기값 = 0.16

Step 2. 다음 레이어로 오차와 기울기 전파

0.2 * 0.16 = 0.032

Step 3. 더 깊은 레이어에서의 계산

0.032 * 0.16 = 0.00512

=>오차출력 × 출력층 기울기값 × 이전 층 기울기값 ×…=최종 기울기 값

0에 수렴함…

2차 침체기

(80년대 후반 - 90년대 초중반)

이유1 : 기술적 한계

- 앞서 말했던 기울기 소실 문제 등

이유2 : 컴퓨터 성능 한계

- 신경망과 같은 알고리즘은 대규모 데이터를 다루기 위해 고성능 연산 능력이 필요했습니다.

그러나 당시에는 주로 단일 코어 CPU를 사용하였고, 병렬 연산이 제한적이었습니다. 당시 CPU의 클럭 속도는 25에서 100MHz 수준으로, 오늘날의 GHz 단위 성능과 비교했을 때 매우 낮았습니다.이로 인해 대규모 데이터를 처리하거나 복잡한 연산을 수행하는 것이 거의 불가능했습니다.

또한, 메모리와 저장장치의 용량도 매우 적었기 때문에, 데이터의 저장과 처리 속도가 상당히 제한적이었습니다. 이러한 컴퓨팅 자원의 부족은 인공지능 알고리즘이 실질적으로 작동할 수 없도록 만들었습니다.

이유3 : 데이터의 부족

- 1990년대에는 데이터가 충분히 축적되지 않았고, 특히 이미지, 음성과 같은 비정형 데이터를 분석하는 것은 매우 어려웠습니다. 예시로 1990년대의 음성 인식 시스템을 들 수 있습니다. 음성 인식을 위해 은닉 마르코프 모델이 주로 사용되었지만, 음성 데이터를 대규모로 수집하는 것이 어려워 충분한 학습이 이루어지지 않았습니다.이는 음성 인식 모델의 성능을 제한했으며, 음성 인식 기술의 상용화를 어렵게 만들었습니다. 대규모 데이터 부족은 기계 학습 모델이 충분히 학습하지 못하게 하여 AI 성능을 크게 저하시켰습니다.

이유4 : 실망스러운 성과

초기 인공지능 연구는 많은 기대를 받았으나, 상용화된 AI 제품들이 예상만큼 성과를 내지 못했습니다. 이로 인해 인공지능에 대한 기대가 점점 식게 되었고, 정부와 기업들의 투자도 급격히 감소하였습니다.기술적 한계로 인해 실제로 상용화된 AI 제품이 기대한 만큼 성능을 발휘하지 못했으며, 이는 연구 자금 감소로 이어졌습니다. 결국, 인공지능 연구는 자금 부족과 성과 부재의 악순환에 빠져들게 되었습니다.

그러나 이 침체기는 이후 2000년대 들어 데이터 양의 증가, GPU의 발전, 딥러닝의 재발견을 통해 극복되었으며, 현재의 인공지능 붐으로 이어지게 되었습니다.

3차 AI 붐

(머신러닝 딥러닝의 발전)

- 머신러닝 기술 수요 급증

1990년대에 월드와이드웹의 출현은 인터넷 보급에 혁명적인 변화를 가져왔습니다. 인터넷은 일반 가정에서도 사용할 수 있게 되었고, 수많은 웹사이트들이 등장하면서 대량의 데이터가 생성되기 시작했습니다. 이로 인해 웹상에서 생성되는 방대한 데이터를 처리하고, 분석하며 활용하고 싶은 수요가 급격히 증가했습니다. 당시 기업들은 이러한 데이터를 단순히 저장하는 것뿐만 아니라, 더 효율적으로 처리하고 활용하기 위한 방법을 모색하기 시작했습니다.구글이나 아마존 같은 기업에서도 방대한 데이터를 처리하고 사용자 맞춤형 경험을 제공하고자 머신러닝 기술을 사용했습니다. - 머신러닝의 실용적 적용

이러한 수요를 충족시키기 위해 지금에 비하면 상대적으로 단순한 머신러닝 알고리즘들이 많이 사용되었습니다. 이러한 알고리즘은 실제 응용 분야에서 매우 효과적인 성과를 보였습니다. IBM의 딥블루는 체스 전략의 패턴을 분석하여 세계 체스 챔피언를 이기는 성과를 거두었습니다. 이는 인공지능이 체스와 같은 복잡한 게임에서 인간을 능가할 수 있음을 증명한 첫 사례였으며, 패턴 인식 및 전략 분석을 통해 머신러닝이 실질적으로 활용될 수 있는 가능성을 보여주었습니다.

인공신경망의 부활과 딥러닝의 등장

- 2006년

힌튼은 ‘심층 신뢰 신경망’을 발표함. - 심층 신뢰 신경망이란?

여러층의 (Restricted Boltzmann Machines, RBM)**으로 구성된 신경망입니다.

각 층은 비지도 학습 방식으로 사전훈련(Pretraining)한 후, 전체 네트워크를 미세 조정한다. - 과정설명

1. 사전훈련(Pretraining)

신경망에서 각 층을 따로따로 학습시키는 방법

이때 비지도학습(정답이 없이 각 층이 스스로 데이터를 학습하여 중요한 패턴을 파악)을 하게 된다.

2. 미세 조정(Fine-Tuning)

전체 신경망을 한번에 미세조정하는 단계이다.

이때 지도학습(정답이 있는 데이터를 사용)하는 방식으로 오차를 최소화하도록 신경망이 조정된다.

=> 기존의 인공신경망의 한계를 뛰어넘은 인공신경망을 ‘딥러닝’이라고 부르기 시작!

딥러닝의 성장

- 2012년

알렉스 넷이 ILSVRC(ImageNet Large Scale Visual Recognition Challenge)에서 우승

다. 딥러닝 기반의 모델인 알렉스넷은 이미지 인식률 84.7%를 기록했는데, 이는 다른 모델과 비교했을 때 월등히 높은 수치였다. 특히, 전년도 우승팀의 오류율 25.8%를 무려 16.4%까지 낮추는 기염을 토했다. - 2016

알파고와 이세돌의 대국

구글 딥마인드가 개발한 AI 알파고(AlphaGo)가 4승 1패로 바둑기사 이세돌 9단을 꺾으며 승리, 전 세계에 AI의 존재를 각인한 것이다. 알파고는 딥러닝 알고리즘과 강화학습*, 몬테카를로 트리 탐색* 알고리즘을 결합해 탄생했다.

*강화학습(Reinforcement Learning): AI가 행동을 학습하는 방식 중 하나. 행동에 따른 결과를 보상의 형태로 알려주면서, 주어진 상태에서 최적의 행동을 선택하는 전략을 찾게 한다.

*몬테카를로 트리 탐색(Monte Carlo tree search, MCTS): 일련의 난수를 반복적으로 생성하여 함수의 값을 수리적으로 근사하 는 확률적 알고리즘의 일종. 현 상황에서 선택 가능한 행동들을 탐색 트리로 구조화하고, 무작위적 시뮬레이션을 통해 각 행동의 득실을 추론하여 최적의 행동을 결정하는 기능을 한다.

'ai' 카테고리의 다른 글

| 기술 검토의 중요성 (1) | 2024.11.09 |

|---|